Sběr dat z provozu

Je jedním ze základních kamenů, na kterých stojí digitalizace průmyslu. Hloubková analýza informací ze senzorů na strojích dokáže podnikům pomoci s automatizací, plánováním výroby i diagnostikou výrobních zařízení. Avšak k tomu, aby bylo možné sběr a vyhodnocování tak obrovského množství informací provádět. Je třeba mít také robustní infrastrukturu, která zvládne zajistit celý životní cyklus dat a také tým profesionálů pro vyhodnocování informací.

Obecně by se dalo říci, že ke sběru a práci s daty je možné přistoupit několika způsoby.

Přičemž každé řešení je platné a vhodné pro různé podniky. Data je možné ukládat a zpracovávat buď v rámci společnosti na interních serverech. Případně je možné je odesílat do cloudu nebo s nimi pracovat v takzvaném hybridním módu. Což znamená, že část dat je uložená na lokálních firemních serverech a část v cloudu.

Pokud se podnik rozhodné používat služby v cloudu, je třeba počítat s nutností rychlejšího datového připojení k Internetu než v případě on premise, tedy lokálního řešení.

Získávání dat, stejně jako ukládání, analýza a vizualizace se následně provádí pomocí softwarových nástrojů a vyhodnocování může probíhat zpětně i v reálném čase.

- Pro efektivní využití dat je ale nesmírně důležitý i lidský prvek:

- tým odborníků složený z datových analytiků a vědců

- profesí zaštiťující funkční infrastrukturu, bezpečnost, architekturu i vývoj.

Bez nich podnik nebude schopen výsledné informace správně vyhodnotit a promítnout je do příslušných procesů ve firmě a získaná data zůstanou více méně ladem. Vybudování vlastního týmu je však časově i finančně velice náročné a každá firma by si měla nejdříve detailně propočítat, zda se jí takové řešení vyplatí, nebo zda a v jakém poměru je výhodnější využívat pro práci s daty outsourcované služby.

Ať už se firma rozhodne jít cestou cloudu či interního sběru a zpracování dat, bude potřebovat komplexní platformu. Ta se skládá se z výkonného hardwaru i speciálního softwaru. Hardwarovou část představují:

- servery například od společností HP, Lenovo, Fujitsu, DELL,

- síťové prvky,

- rakové skříně,

- disková úložiště

- záložní napájení.

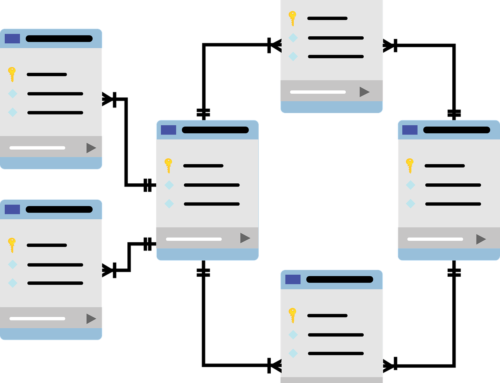

Jednotlivé servery ještě mohou být zapojeny do clusterů, mezi které se úlohy distribuují a každý cluster má na starosti zpracovávání konkrétních dat.

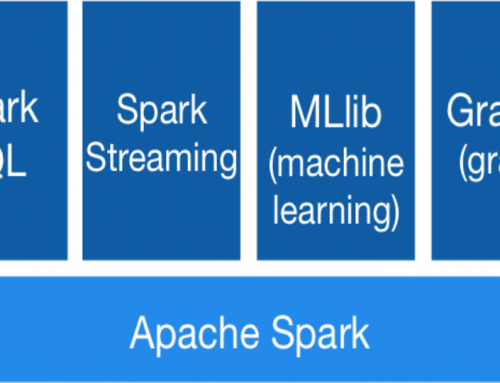

Softwarová část náleží operačnímu systému (zejména různým distribucím Linuxu) a nástrojům určeným pro vlastní zpracování dat jako například:

- open source Apache Hadoop

- Apache Spark

nad nimiž se dá postavit unikátní řešení pro danou společnost a to včetně nástrojů pro analýzu a vizualizaci dat.

Celá infrastruktura musí být navržena tak, aby dokázala distribuovat desítky a stovky terabytů až jednotky petabytů dat při přenosové rychlosti 100 Mbps až 10 GBps.

Inteligentně zpracovaná data

Vlastní zpracování dat

Probíhá v procesech nad interně či v cloudu uloženými daty. Buď dávkově, tedy v přesně stanovených intervalech, nebo v reálném čase. Zásadní rozdíl v těchto dvou konceptech lze přirovnat k jízdě v autě, kde se v případě dávkového způsobu zpracování dat „díváme do zpětných zrcátek“ a sledujeme události, které se odehrály za určitý časový úsek.

V případě zpracování dat v reálném čase se díváme na minulost starou jen několik zlomků sekundy. Na základě takto rychle analyzovaných a vizualizovaných dat z výroby (například z IoT senzorů na strojích) může člověk či počítač bezprostředně konat. Čili se rozhodovat o dalších operacích tak, aby se při výrobě zamezilo případným ztrátám, nebo naopak aby se zvýšila efektivita produkce.

Zpracování dat však nemusí být pouze o prostém „statistickém“ vyhodnocování získaných údajů. Přidaná hodnota práce s velkými objemy dat totiž tkví v možnosti užití prvků umělé inteligence, například (hlubokého) strojového učení.

Strojové učení je typ umělé inteligence

Díky které se počítače dokážou učit na základě získaných informací. Učení probíhá za pomoci tréninkových dat buď „s učitelem“ (datovým expertem), nebo bez něj.

Existuje ale také zpětnovazební učení, které funguje na principu vybírání vhodného řešení z mnoha možností. Velká výhoda oproti dvěma předchozím principům je v tom, že systém nepotřebuje cvičná data. Trénuje na reálných datech zadaných expertem a dokáže se mu plně vyrovnat či ho dokonce v dovednostech překonat. Tento postup se opírá o poznatky z behaviorální psychologie a hojně se využívá se právě v průmyslu.

Nutno ale podotknout, že samotný proces učení je samozřejmě závislý na množství a kvalitě používaných dat a přímo souvisí se složitostí procesu, který je třeba zautomatizovat. Učení tedy může trvat dny i měsíce a v případě těch opravdu složitých operací i roky. Výsledky učení ale v praxi mohou vypadat třeba tak, že při použití vhodného algoritmu pro oblast kontroly kvality výrobků můžeme postupně celý systém kontroly jakosti plně automatizovat.

Sledováním zvuků a vibrací strojů či kvality výrobků zase můžeme predikovat jejich „zdravotní“ stav a přesněji tak odhadovat údržbu. A aby toho nebylo málo, i takto složité úkony je v konečném důsledku možné provádět v reálném čase. Sběr a hlavně správně zvolená metoda analýzy dat z výroby tedy může vést k okamžitému a pozitivnímu vlivu na finance.

Nástroje pro sběr a analýzu dat

Je možné propojit i s vnitropodnikovými systémy (i těmi v cloudu) pro obousměrné využívání. ERP totiž sám o sobě funguje jako téměř bezedná databanka strukturovaných informací o procesech řízení zásob, výroby a dodavatelského řetězce. Díky integraci nástrojů pro analýzu dat se všechna tato data mohou vyhodnocovat v reálném čase, což podnikům může přinést zlepšení na poli rozhodování a řízení celého procesu výroby i logistiky.

Autoři: Martin Štufi a Kristina Kadlas Blümelová