Pro umělou inteligenci (AI) nastává vzrušující doba. Podniky kombinují možnosti AI s podnikovými daty, aby dosáhly lepších výsledků pro zaměstnance, zákazníky a partnery. S tím, jak organizace hlouběji začleňují AI do svých systémů, se tato data a infrastruktura stávají atraktivnějšími cíli pro kyberzločince a další protivníky.

Zejména generativní umělá inteligence (gen AI) zavádí nová rizika tím, že výrazně rozšiřuje oblast útoku organizace. To znamená, že podniky musí pečlivě vyhodnotit potenciální hrozby, zranitelnosti a rizika, která přinášejí do obchodních operací. Nasazení umělé inteligence se silným bezpečnostním systémem, v souladu s předpisy a důvěryhodným způsobem vyžaduje více než jen roztříštěnou obranu, vyžaduje strategickou změnu. Zabezpečení nemůže být druhořadou záležitostí – musí být součástí celé strategie umělé inteligence.

Zabezpečení umělé inteligence vs. bezpečnost umělé inteligence

Bezpečnost umělé inteligence a ochrana před umělou inteligencí jsou související, ale odlišné koncepty. Oba jsou nezbytné pro snížení rizika, ale řeší různé výzvy.

Zabezpečení umělé inteligence

Zabezpečení umělé inteligence se zaměřuje na ochranu důvěrnosti, integrity a dostupnosti systémů umělé inteligence. Cílem je zabránit zlomyslným aktérům v útoku na tyto systémy nebo v jejich manipulaci.

Hrozby mohou vznikat z:

- Zneužívání zranitelností v softwarových komponentách

- Špatně nakonfigurované systémy nebo nefunkční ověřování umožňující neoprávněný přístup k citlivým podnikovým datům

- Okamžitá injekce nebo modelový „jailbreaking“

Jinými slovy, zabezpečení pomocí umělé inteligence vypadá velmi podobně jako tradiční zabezpečení IT, ale aplikované na nové typy systémů.

Bezpečnost umělé inteligence

Bezpečnost umělé inteligence pomáhá udržovat zamýšlené chování systémů umělé inteligence a udržuje je v souladu s firemními politikami, předpisy a etickými standardy. Rizika se zde netýkají narušení systému, ale toho, co systém produkuje.

Mezi bezpečnostní problémy patří:

- Škodlivý nebo toxický jazyk

- Zaujatost nebo diskriminace v reakcích

- Halucinace (věrohodně znějící, ale falešné odpovědi)

- Nebezpečná nebo zavádějící doporučení

Bezpečnostní selhání může narušit důvěru, způsobit poškození pověsti a dokonce vytvořit právní nebo etické závazky.

Příklady bezpečnostních a ochranných rizik

|

Zabezpečení umělé inteligence |

Bezpečnost umělé inteligence |

|

Problémy se zabezpečením paměti: Inferenční software a další komponenty systému umělé inteligence mohou být zranitelné vůči tradičním problémům se zabezpečením paměti. Například přetečení haldy v knihovně pro manipulaci s obrázky může útočníkovi umožnit manipulovat s klasifikací provedenou modelem. |

Zaujatost: Modelové odpovědi diskriminují sociální skupinu na základě rasy, náboženství, pohlaví nebo jiných osobních charakteristik. |

|

Nezabezpečené konfigurace: MCP server nástroje je vystaven internetu bez ověřování a útočníci se přes něj mohou dostat k citlivým informacím. |

Halucinace: Model si vymýšlí reakce, které nejsou založeny na faktech. |

|

Nefunkční ověření nebo autorizace: K funkcím serveru MCP je možné přistupovat pomocí uživatelského tokenu namísto použití specifického omezeného tokenu pro klienta MCP. |

Škodlivé reakce: Model poskytuje reakce, které mohou uživatelům způsobit škodu. Například pokud poskytuje nebezpečné lékařské rady. |

|

Malware: Útok v dodavatelském řetězci, kdy je škodlivý kód přidán do důvěryhodného modelu s otevřeným zdrojovým kódem. |

Toxický jazyk: Modelové odpovědi obsahují urážlivý nebo hanlivý obsah. |

|

Jailbreaking: Obejděte vestavěné bezpečnostní kontroly LLM a extrahujte omezený obsah. |

Nová hranice rizika: Demystifikace „bezpečnosti“

I když je základní bezpečnost klíčová, modely velkých jazyků (LLM) zavádějí další rizikovou oblast: bezpečnost. Na rozdíl od tradičního používání tohoto termínu znamená bezpečnost v kontextu umělé inteligence důvěryhodnost, spravedlnost a etický soulad.

- Selhání zabezpečení by mohlo odhalit citlivá data.

- Bezpečnostní selhání může vést k zaujatým doporučením k náboru, toxickým reakcím v chatbotu pro zákazníky nebo jiným výstupům, které podkopávají důvěru.

Proč se to děje? LLM jsou trénováni k předpovídání „dalšího slova“ na základě trénovacích dat, nikoli k rozlišování mezi pravdou a leží. Snaží se také odpovědět na každou otázku, a to i na ty, na které nebyli trénováni. Připočtěte k tomu jejich nedeterministickou povahu, skutečnost, že se odpovědi liší i na stejnou výzvu, a dostanete nepředvídatelné výsledky.

Tato nepředvídatelnost vytváří problémy v oblasti správy a řízení. I s bezpečnými trénovacími daty může model stále generovat škodlivý obsah. Jemné doladění může také oslabit vestavěné ochranná opatření, někdy neúmyslně.

Řízení těchto rizik vyžaduje novou sadu nástrojů:

- Předškolení a seřízení zaměřené na bezpečnost

- Průběžné hodnocení a srovnávání výsledků v oblasti bezpečnosti

- „Využití hodnocení LLM“ k měření pravděpodobnosti škodlivých výstupů, stejně rutinních jako testování výkonu

Klíčem je uvědomit si, že škodlivý výstup je obvykle bezpečnostní problém, nikoli tradiční bezpečnostní chyba.

Měl by model umělé inteligence získat veškerou pozornost?

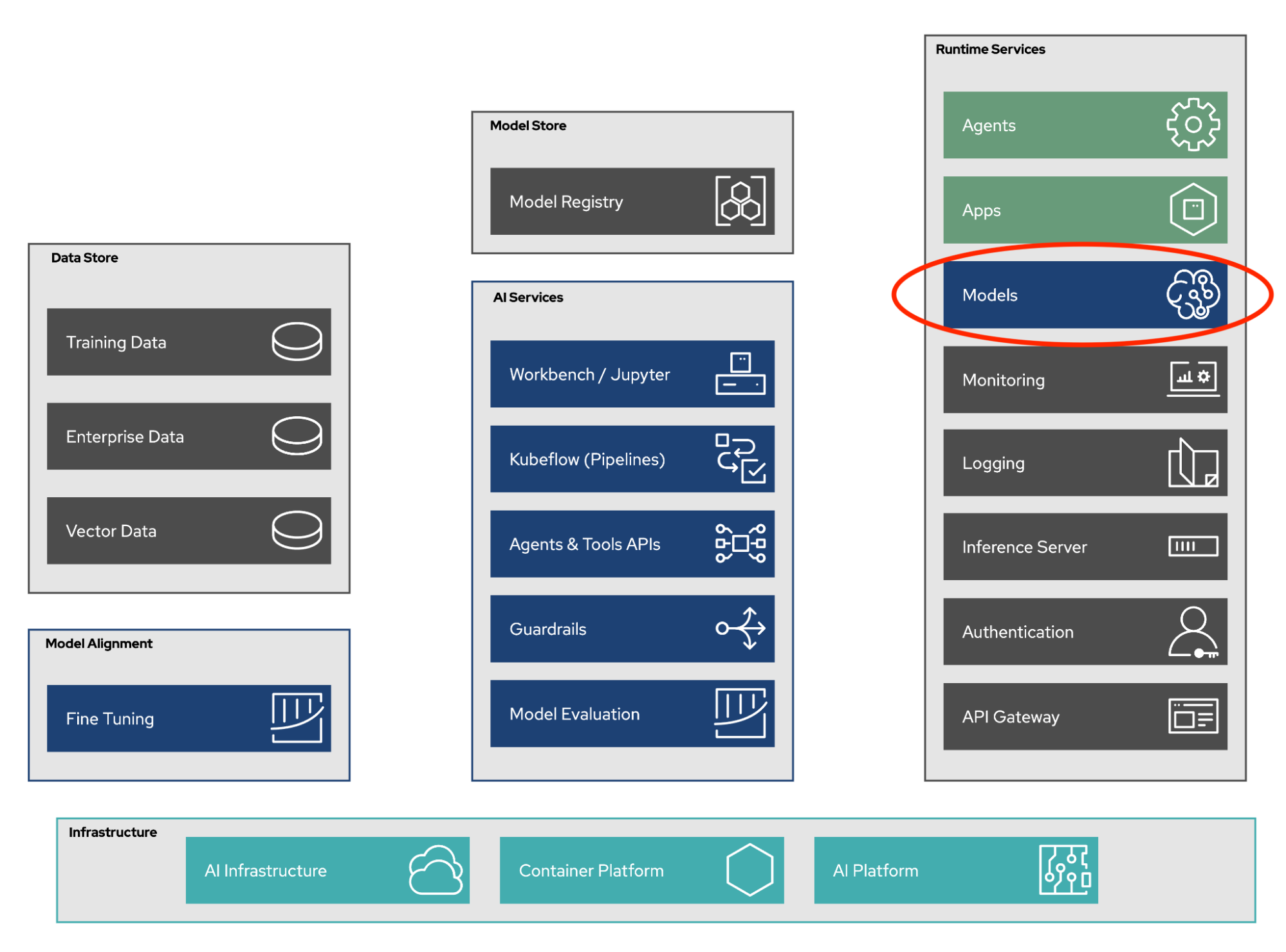

Modely umělé inteligence často přitahují pozornost, ale jsou pouze jednou součástí širšího systému umělé inteligence. Ve skutečnosti komponenty, které nepatří mezi umělou inteligenci (servery, API, orchestrační vrstvy), často tvoří většinu systému a nesou svá vlastní rizika.

Obrázek 1: Komponenty systému umělé inteligence

Správným přístupem je strategie hloubkové obrany – posílení stávajících podnikových bezpečnostních postupů a následné přidání dalších ochran proti novým rizikům, která generativní umělá inteligence přináší.

Sjednocení zabezpečení umělé inteligence s podnikovou kybernetickou bezpečností

Zabezpečení umělé inteligence není o znovuvynalézání kola. Platí zde stejné principy, které jsou základem tradičního podnikového zabezpečení. Ve skutečnosti jsou vaše stávající investice do kybernetické bezpečnosti základem vašeho zabezpečení v oblasti umělé inteligence.

Bezpečnost se zaměřuje především na řízení rizik – snižování pravděpodobnosti vzniku hrozby a minimalizaci jejího dopadu, pokud k ní dojde.

To znamená:

- Modelování rizik pro identifikaci a prioritizaci rizik souvisejících s umělou inteligencí

- Penetrační testování pro měření robustnosti

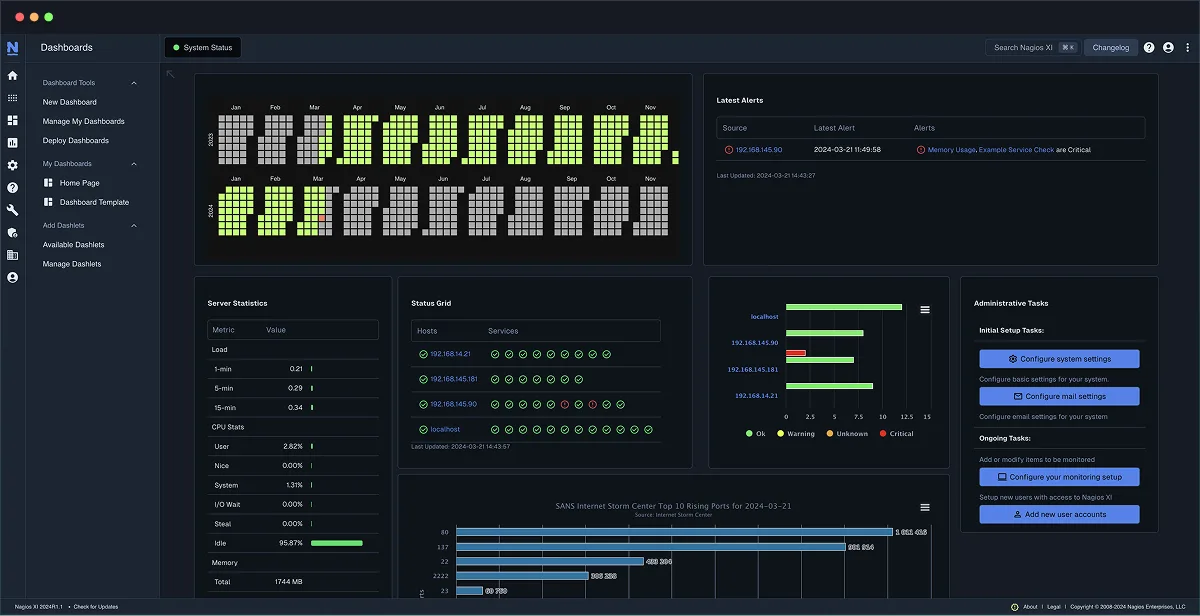

- Neustálé monitorování pro detekci a reakci na incidenty

Klasická triáda Důvěrnost, Integrita, Dostupnost (CIA) stále platí, ať už je systém poháněn umělou inteligencí, nebo ne. Pro posílení zabezpečení umělé inteligence by podniky měly rozšířit osvědčené postupy, včetně:

- Bezpečný životní cyklus vývoje softwaru (SDLC): Začlenění zabezpečení do každé fáze. Frameworky, jako je Red Hat SDLC, znamenají, že zabezpečení je součástí celého vývojového procesu, nikoli něčím, co se přidává později.

- Bezpečný dodavatelský řetězec: Prověřování každého modelu, knihovny a kontejneru za účelem ochrany před zranitelnostmi nebo škodlivým kódem.

- Nástroje SIEM (Security Information and Event Management) a SOAR (Security Orchestration, Automation, and Response): Monitorování vstupů, zátěže systému a možného úniku dat.

Podniky by měly také integrovat rizika spojená s umělou inteligencí do stávajících rámců správy a řízení, jako je systém řízení bezpečnosti informací (ISMS), spíše než vytvářet samostatné programy AI. Pokud budete k bezpečnosti AI přistupovat jako k rozšíření stávajícího systému, můžete využít stejné dovednosti, nástroje a procesy k efektivnějšímu pokrytí většiny rizik.

Pohyb vpřed

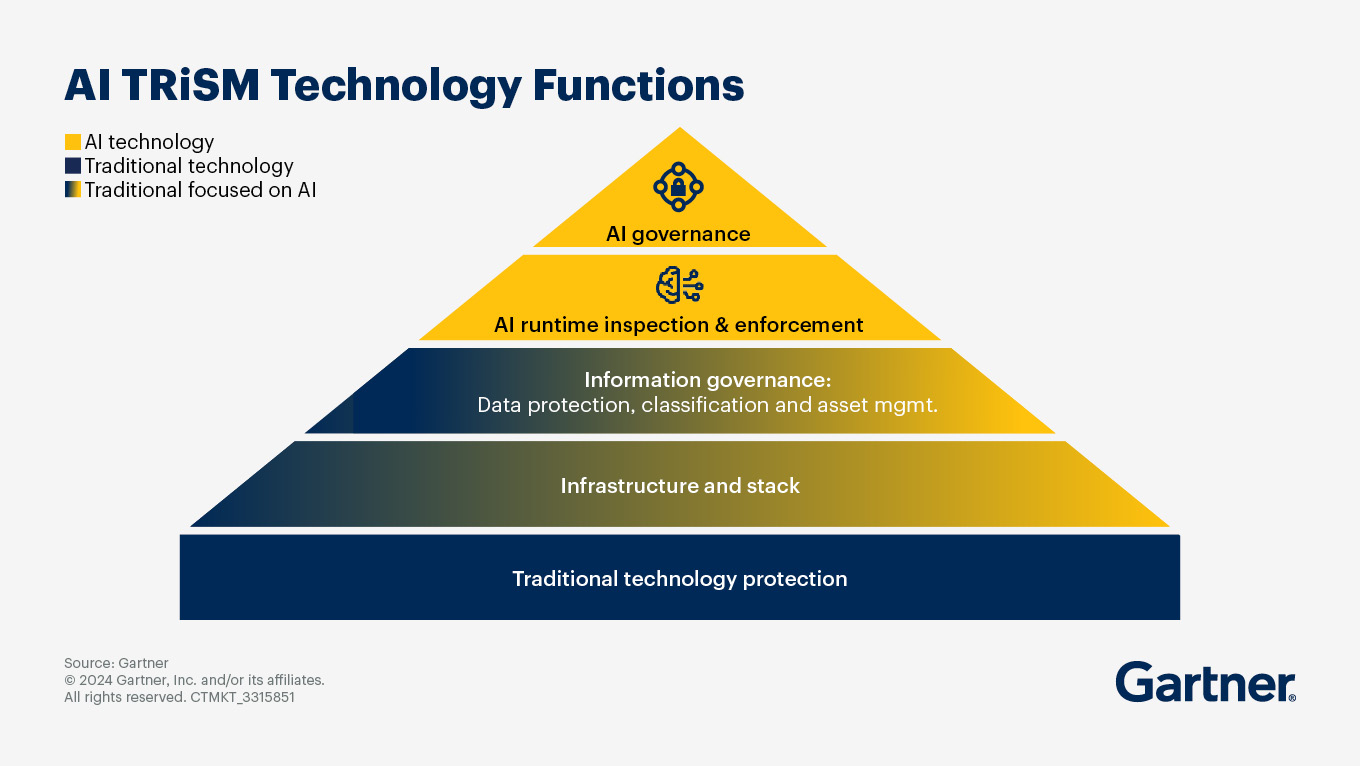

Stručně řečeno, podniky by měly k bezpečnosti a ochraně umělé inteligence přistupovat holisticky. Rámce zdůrazňují potřebu integrovaného řízení rizik, které kombinuje bezpečnost, správu a dodržování předpisů se specifickými ochrannými opatřeními pro umělou inteligenci.

Obrázek 2: Rámec Gartner AI TRiSM

Sečteno a podtrženo, umělá inteligence přináší obrovské příležitosti, ale také jedinečná rizika. Sjednocením zabezpečení umělé inteligence se zavedenými postupy kybernetické bezpečnosti a vrstvením bezpečnostních opatření mohou podniky vybudovat důvěryhodnější systémy, které přinášejí obchodní hodnotu.

Závěrem

Bezpečnost umělé inteligence a její ochrana jsou dvě strany téže mince – jedna se zaměřuje na ochranu systémů před útoky, druhá na posílení odpovědného a důvěryhodného chování. Podniky, které považují bezpečnost a ochranu umělé inteligence za nedílnou součást své celkové strategie řízení rizik, budou mít nejlepší pozici k tomu, aby uvolnily obchodní hodnotu umělé inteligence a zároveň si zachovaly důvěru zákazníků, zaměstnanců a regulačních orgánů.

Projděte si svou cestu umělou inteligencí s Red Hat. V případě jakýchkoli dotazů nebo připomínek se na nás prosím obraťte.

Zdroj: Red Hat