S rostoucím zaváděním cloudových systémů umělé inteligence v podnicích se jejich ochrana stala prioritou pro týmy kybernetické bezpečnosti. Stínová umělá inteligence – nekontrolované a neschválené používání aplikací a služeb umělé inteligence – se ukázala jako obzvláště kritická hrozba. Zde uvádíme dva osvědčené postupy, které vám mohou pomoci v boji proti stínové umělé inteligenci ve vašich cloudových úlohách.

Ochrana vašich systémů umělé inteligence před kybernetickými útoky je mnohostranný úkol, ale jeho základem je přehled o stavu. Potřebujete kompletní a průběžně aktualizovaný inventář všech vašich prostředků umělé inteligence. Každé neznámé zařízení umělé inteligence je potenciálním vektorem útoku, protože jeho bezpečnostní nedostatky nejsou řešeny.

Jak uvádí Aliance pro cloudovou bezpečnost ve své zprávě „Odpovědnosti organizace v oblasti AI“: „Řešení problému stínové AI – neoprávněných nebo nezdokumentovaných systémů AI v rámci organizace – je nezbytné pro udržení kontroly, zabezpečení a dodržování předpisů v provozu AI.“

Bohužel je přítomnost těchto neviditelných prostředků umělé inteligence poměrně běžná. Hlavním viníkem jsou jednotliví zaměstnanci a týmy, kteří zavádějí nástroje umělé inteligence, aniž by informovali IT oddělení. Různé zprávy, včetně zpráv od společností Software AG a Salesforce, odhadují, že přibližně polovina zaměstnanců používá v práci neschválené nástroje umělé inteligence.

Národní aliance pro kybernetickou bezpečnost (NCA) ve své zprávě „Oh, Behave! The Annual Cybersecurity Attitudes and Behaviors Report 2024-2025“ zjistila, že téměř 40% zaměstnanců poskytlo firemní data nástrojům umělé inteligence bez souhlasu své organizace.

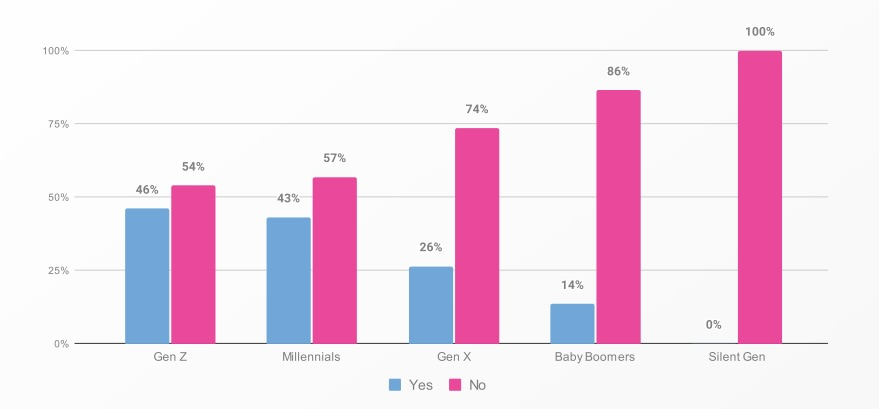

Sdíleli jste někdy citlivé pracovní informace s nástroji umělé inteligence bez vědomí vašeho zaměstnavatele?

(Zdroj: Studie „Oh, Behave! The Annual Cybersecurity Attitudes and Behaviors Report 2024–2025“ od Národní aliance pro kybernetickou bezpečnost, září 2024, na základě průzkumu mezi 1 862 respondenty z USA, Kanady, Velké Británie, Německa, Austrálie, Nového Zélandu a Indie.)

A dopad stínové umělé inteligence má skutečné důsledky. Ve své zprávě „AI Barometer: October 2024“ zjistil průzkumník trhu Vanson Bourne, že stínová umělá inteligence ztěžuje 60% dotázaných organizací kontrolu správy dat a dodržování předpisů.

Do jaké míry si myslíte, že neoprávněné používání nástrojů umělé inteligence ovlivňuje schopnost vaší organizace udržet si kontrolu nad správou dat a dodržováním předpisů?

(Zdroj: „AI Barometer: říjen 2024“ od Vansona Bournea)

Mezitím, jak ukazuje naše „Zpráva o rizicích AI v cloudu Tenable za rok 2025“, se v nasazených cloudových službách umělé inteligence vyskytuje hojně slabých a výchozích konfigurací. Na základě telemetrie z veřejných cloudových a podnikových úloh skenovaných pomocí produktů Tenable mezi prosincem 2022 a listopadem 2024 zpráva zjistila, že:

- 91% organizací s nastaveným Amazon SageMaker mělo riskantní výchozí nastavení root přístupu (tj. administrátorských oprávnění) alespoň v jedné instanci notebooku – což uživatelům umožňovalo měnit systémově kritické soubory, včetně těch, které přispívají k modelu umělé inteligence.

- 14% organizací používajících Amazon Bedrock explicitně neblokovalo veřejný přístup k alespoň jednomu školicímu balíčku pro umělou inteligenci – a 5% mělo alespoň jeden příliš tolerantní balíček.

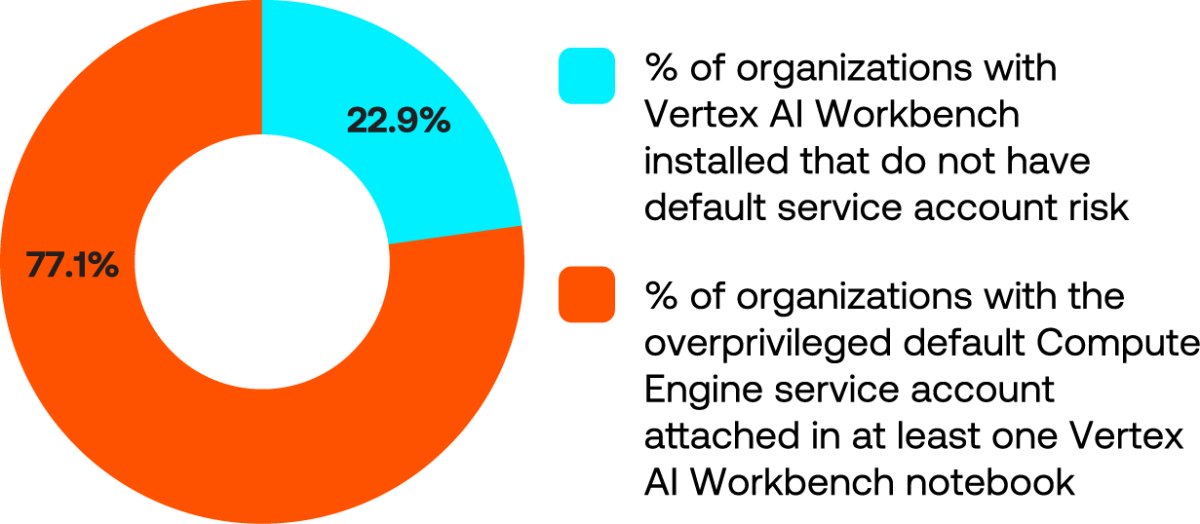

- 77% organizací mělo nakonfigurovaný nadprivilegovaný výchozí servisní účet Compute Engine v alespoň jednom notebooku Google Vertex AI Workbench. Všechny služby postavené na tomto výchozím Compute Engine jsou ohroženy.

(Zdroj: „Zpráva o rizicích Tenable Cloud AI za rok 2025“, březen 2025)

V tomto blogu vám nabízíme dva způsoby, jak řešit hrozbu stínové umělé inteligence ve vaší organizaci.

Nejlepší postup č. 1: Získejte přehled o všech cloudových aktivech AI a ML

- Nejlepší postup: Identifikujte všechny cloudové služby a zdroje umělé inteligence (např. instance strojového učení, API umělé inteligence, úložiště trénovacích dat) používané ve vašem prostředí.

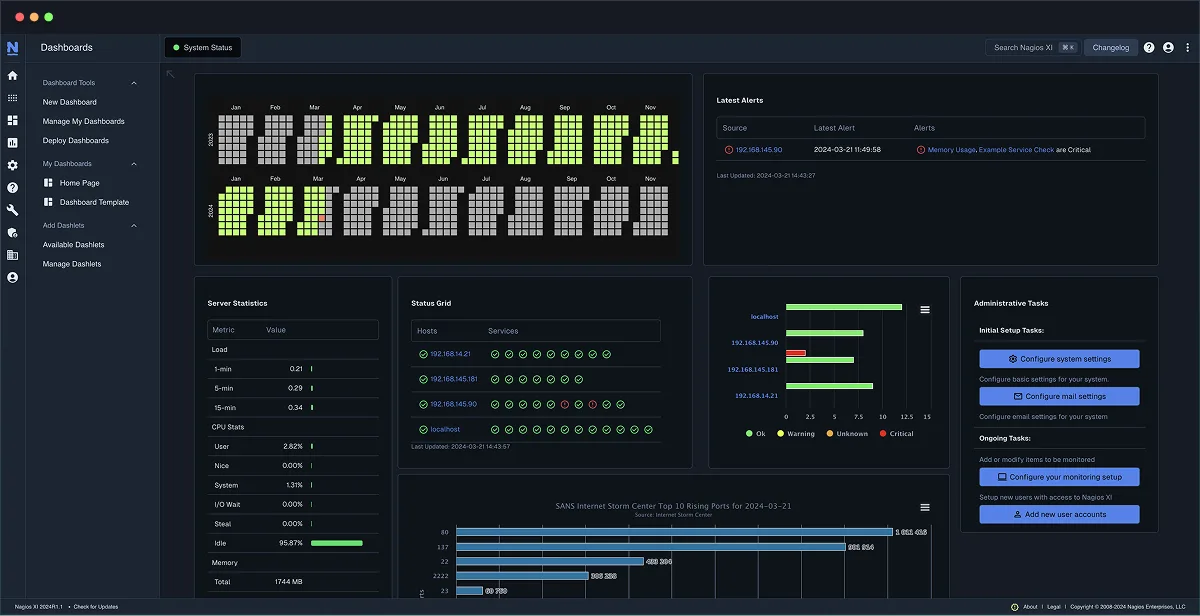

- Akce: Použijte řídicí panely poskytovatelů cloudu nebo nástroj platformy pro ochranu cloudových aplikací (CNAPP) k zobrazení všech spuštěných služeb AI/ML, jako jsou úlohy AWS SageMaker, Azure Cognitive Services, GCP Vertex AI a další. Označte nebo inventarizujte tato aktiva, abyste věděli, co máte.

- Hodnota: Okamžitý přehled zajišťuje, že máte přehled o každé úlohě umělé inteligence. Nemůžete chránit to, o čem nevíte – tento krok odhalí veškerá nespravovaná aktiva umělé inteligence, která by mohla představovat skryté riziko.

Nejlepší postup č. 2: Zpřísnění řízení přístupu a oprávnění umělé inteligence

- Nejlepší postup: Omezte, kdo a co má přístup k modelům, API a datům umělé inteligence. Používejte princip nejnižších oprávnění pro uživatelské účty a servisní role interagující s prostředky umělé inteligence.

- Akce: Zkontrolujte a odstraňte všechny příliš široké role IAM nebo klíče API s nadměrnými oprávněními ke službám AI. Implementujte přístup založený na rolích, aby model AI mohly vyvolat nebo číst jeho data pouze konkrétní týmy nebo aplikace. Používejte nástroje pro cloudovou identitu nebo funkce správy oprávnění cloudové infrastruktury (CIEM) k automatické detekci a nápravě nadměrných oprávnění souvisejících s AI.

- Výhoda: Omezení přístupu výrazně snižuje riziko neoprávněného použití nebo úniku dat. Můžete tak uzavřít zjevné mezery v oprávněních a zabránit například tomu, aby nedůvěryhodný účet odčerpával citlivá data, nebo aby dobře míněný, ale neoprávněný zaměstnanec spustil novou službu umělé inteligence.

Závěrem

Platforma Tenable Cloud Security CNAPP nabízí řadu funkcí, které pomáhají zmírnit hrozbu stínové umělé inteligence ve vašich cloudových úlohách, včetně správy zabezpečení umělé inteligence (AI-SPM), správy zabezpečení dat (DSPM) a správy oprávnění cloudové infrastruktury (CIEM). Platforma automaticky vyhledává prostředky umělé inteligence a citlivá data napříč cloudy, vynucuje konfigurace osvědčených postupů a minimální oprávnění a průběžně monitoruje rizika v podnikovém měřítku.

Chcete-li získat více informací, neváhejte nás kontaktovat.

Zdroj: Tenable