Zásady přijatelného používání umělé inteligence mohou vaší organizaci pomoci zmírnit riziko, že zaměstnanci nechtěně zpřístupní citlivá data veřejným nástrojům umělé inteligence. Porovnejte zásady vaší organizace s našimi osvědčenými postupy a zjistěte, jak viditelnost na úrovni okamžitého upozornění od Tenable AI Exposure usnadňuje vymáhání zásad.

Vydání ChatGPT společností OpenAI v listopadu 2022 bylo seismickou událostí. ChatGPT, postavený na modelu velkých jazyků GPT 3.5 (LLM), se podle UBS rychle stal nejrychleji rostoucím spotřebitelským produktem vůbec se 100 miliony uživatelů měsíčně za 60 dní. V podobném časovém úseku se také projevila rizika této průlomové technologie.

Začátkem roku 2023 dva zaměstnanci elektronické společnosti sdíleli důvěrný zdrojový kód se společností ChatGPT, čímž se jejich zdrojový kód stal součástí školicích dat LLM, aniž by si to uvědomovali. Incident, o kterém se široce psalo v médiích, vedl mnoho organizací k zákazu veřejných nástrojů umělé inteligence. Nejednalo se o ojedinělý případ. Globální průzkum provedený Melbournskou univerzitou začátkem roku 2025 ukázal, že 48% zaměstnanců nahrálo citlivé informace do veřejných generativních nástrojů umělé inteligence a 44% vědomě porušilo firemní zásady umělé inteligence.

To vše zdůrazňuje naléhavost toho, aby organizace vyvinuly a zavedly jasné a robustní zásady pro přijatelné používání umělé inteligence.

Co je to politika přijatelného používání umělé inteligence (AUP)?

Zásady přijatelného používání umělé inteligence poskytují pokyny pro správné, etické a legální používání technologií umělé inteligence ve vaší organizaci. Tyto zásady by měla spravovat rada pro řízení umělé inteligence, vedená vedoucím členem IT týmu a zahrnující zainteresované strany z celé organizace.

Zásady pro přijatelné používání umělé inteligence by měly zahrnovat:

- Seznam schválených nástrojů (včetně nástrojů schválených pro celofiremní použití a nástrojů schválených pro konkrétní obchodní jednotky).

- Typy dat, které lze a nelze sdílet.

- Pravidla upravující nakládání s daty.

- Pokyny pro používání umělé inteligence k vytváření obsahu.

- Důsledky porušení zásad.

Zásady přijatelného používání umělé inteligence vám pomáhají řídit riziko úniku dat a ztráty duševního vlastnictví tím, že jasně definují, co zaměstnanci mohou a nemohou dělat. Mohou vám také pomoci udržovat soulad s ustanoveními o nakládání s daty v rámci regulačních požadavků, jako je Obecné nařízení o ochraně osobních údajů (GDPR).

Místo toho, aby fungovala jako zatěžující soubor pravidel, by dobře propracovaná politika přijatelného používání umělé inteligence měla zaměstnancům umožnit využívat výhod umělé inteligence a zároveň udržovat rizika pod kontrolou – ať už používají pracovní zařízení nebo svá vlastní osobní.

Klíčové komponenty zásad přijatelného používání umělé inteligence

Víte, že potřebujete průvodce, který vám pomůže řídit používání umělé inteligence. Ale co by měl obsahovat? Na základě mnoha rozhovorů se zákazníky, kteří se s tímto problémem potýkali, doporučujeme radám pro řízení umělé inteligence, aby do svých zásad pro přijatelné používání umělé inteligence zahrnuly tyto klíčové komponenty:

- Klasifikace dat: Toto se týká toho, jaká data povolujete a jak zakazujete používat s nástroji umělé inteligence. Vaše zásady by měly jasně stanovit, co zaměstnanci nemohou v umělé inteligenci používat, například osobní údaje zákazníků (PII), zdrojový kód, finanční záznamy a strategické dokumenty o fúzích a akvizicích. Uveďte to podrobně, protože potřeby vaší společnosti jsou pravděpodobně jedinečné. Neomezujte to však na věci, které zaměstnanci dělat nemohou . Sdělte jim, jaké druhy úkolů mohou vykonávat.

- Schválené nástroje: Poskytněte zaměstnancům kompletní seznam schválených a povolených aplikací umělé inteligence (např. nástroje jako Grammarly, ChatGPT Enterprise a Zoom AI jsou často schváleny, zatímco DeepSeek, který je zakázán několika státy USA a vládními agenturami, často schválen není). U schválených nástrojů sdělte zaměstnancům případy použití každého z nich a uveďte interní nebo dodavatelem poskytnutá školicí videa. Možná je jeden vhodný pro kódování a druhý pro tvorbu obrázků. Současně ve svých zásadách jasně uveďte, že neschválené nástroje nejsou povoleny. Kromě toho poskytněte zaměstnancům mechanismus, kterým mohou požádat o schválení nástrojů umělé inteligence.

- Pokyny k použití: Měli byste jasně definovat vhodné obchodní případy užití (dobrým příkladem může být napsání marketingového textu) a nevhodné případy (shrnování citlivých poznámek ze schůzek pravděpodobně není dobrý nápad).

- Odpovědnost: Co se stane, pokud dojde k porušení zásad? Popište důsledky a buďte konkrétní. Pokud k porušení dojde, existuje řada způsobů, jak s ním naložit. My však doporučujeme postupný přístup.

- Například při prvním porušení uživatele jemně varujte a odkažte ho na vaše doporučení pro použití v praxi (AUP). Požádejte také o odůvodnění nástroje a sdělte mu postup pro podání žádosti o přezkum radě pro správu umělé inteligence. Pokud je odůvodnění nástroje jasné, informujte uživatele, že nástroj projde schvalovacím procesem (včetně posouzení rozpočtu a bezpečnosti). Následně rada aktualizuje zásady a upozorní uživatele.

- V případě druhého porušení byste měli uživateli (a dalším zaměstnancům) zablokovat přístup k nástroji.

- Pokud dojde k třetímu porušení, měli byste sledovat opakované pokusy a informovat o tom manažera zaměstnance. Nabídněte zaměstnanci školení a informační zdroje o přijatelném používání nástrojů umělé inteligence.

Porovnejte své zásady pro přijatelné používání umělé inteligence s osvědčenými postupy

Zajistěte, aby zásady přijatelného používání umělé inteligence ve vaší organizaci zahrnovaly následující prvky:

| Využití nástrojů umělé inteligence | Ujistěte se, že máte snadno dostupný seznam schválených a zakázaných nástrojů. Poskytněte zaměstnancům mechanismus, který jim umožní podávat žádosti o nástroje, které by chtěli, aby organizace zvážila ke schválení. |

| Etické principy | Nastíněte pohled vaší organizace na odpovědnost, transparentnost, spravedlnost, bezpečnost, soukromí a ochranu. |

| Požadavky na použití umělé inteligence | Uveďte tři kategorie použití umělé inteligence: povolené (použití je neomezené), zakázané (použití není povoleno) a kontrolované (použití vyžaduje autorizaci). |

| Povinnosti zaměstnanců | Jasně stanovte odpovědnost zaměstnanců za používání umělé inteligence, včetně kontroly přesnosti a zaujatosti a vhodného označení jakéhokoli kódu. Především zaměstnancům jasně sdělte, že organizace nebude tolerovat nezákonné nebo neetické použití umělé inteligence (tj. dezinformace, manipulaci, diskriminaci, pomluvu, narušení soukromí). |

| Ochrana osobních údajů a zabezpečení | Vytvořte směrnice, které respektují práva na soukromí a chrání bezpečnost dat bez ohledu na případ použití umělé inteligence v rámci organizace. |

| Školení a osvěta | Uveďte informace, které zdůrazní váš závazek ke školení o rizicích a důvody, proč nepovolujete používání neschválených nástrojů umělé inteligence, včetně obav týkajících se úniku dat, soukromí, sledování třetími stranami, bezpečnosti (tj. zranitelných nebo nebezpečných nástrojů umělé inteligence, které lze snadno napadnout, a škodlivých aktérů, kteří mohou nástroj umělé inteligence využít k získání opory ve vaší organizaci). Ujistěte se, že si všichni zaměstnanci prostudovali a rozumí dostupným školicím zdrojům. |

Zdroj: Tenable, říjen 2025

Jak vynutit zásady přijatelného používání umělé inteligence

Nyní, když rozumíte riziku a máte zavedené zásady pro přijatelné používání, které jste sdělili zaměstnancům, co bude dál? Musíte je vymáhat. To může být náročné. Ale dovolte nám, abychom vás tím provedli, protože je důležité tento krok udělat správně.

Zde jsou dva klíčové faktory, které zajistí fungování vaší politiky:

- Průběžné školení: Vzdělávejte zaměstnance o důvodech, proč se tato politika skrývá, se zaměřením na reálná rizika. Existuje mnoho příkladů zaměstnanců, kteří sdíleli zdrojový kód, záznamy ze schůzek a další důvěrné informace s veřejnými nástroji umělé inteligence, aniž by si uvědomovali důsledky svých činů, ale protože nechceme nikoho zahanbit, nebudeme je zde uvádět.

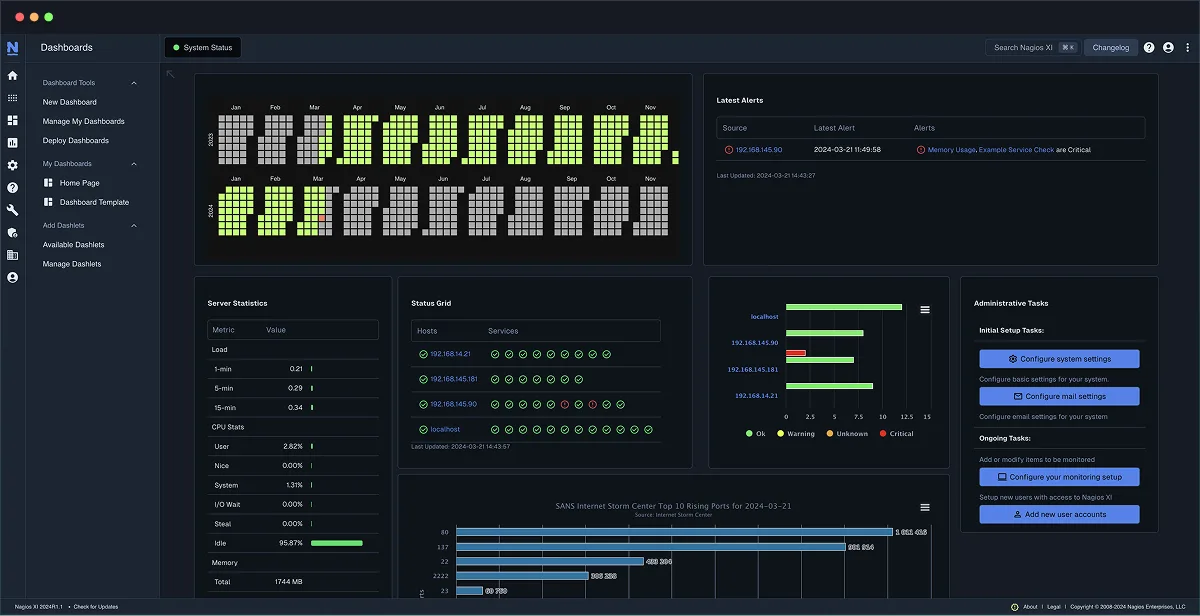

- Proaktivní monitorování a viditelnost: Toto je technické jádro. Nemůžete vynucovat zásady, které nevidíte. Budete muset rychle přejít od pouhého blokování aplikace k detailnímu přehledu o tom, co zaměstnanci dělají, a také o platformách umělé inteligence a agentech umělé inteligence, které používají. Budete také muset znát nástroje třetích stran a pracovní postupy umělé inteligence (ověřené i neověřené), ke kterým mají přístup, aby bylo možné určit rizika na vstupu (výzva), v operacích (co nástroj umělé inteligence dělá v důsledku výzvy) a na výstupu (výsledek vytvořený nástrojem umělé inteligence). Musíte být schopni znát toto vše, abyste pochopili, zda někdo porušuje zásady. Zaměstnanec může žádat o pomoc s Pythonem nebo může kopírovat a vkládat proprietární algoritmus vaší společnosti. Pouze tato úroveň viditelnosti vám umožní rozeznat rozdíl.

Zásady pro přijatelné používání umělé inteligence bez vynucování jsou pouze dokumentem. Abyste svou organizaci skutečně zabezpečili, musíte zkombinovat jasně formulované zásady s proaktivním programem řízení expozice, který poskytuje úplný přehled o tom, jak váš tým tyto výkonné nové nástroje používá.

Jak vám Tenable AI Exposure může pomoci sledovat dodržování zásad přijatelného používání umělé inteligence ve vaší organizaci

Abyste mohli řídit rizika vaší organizace, musíte zabezpečit umělou inteligenci. A musíte pochopit, jak vaši zaměstnanci umělou inteligenci používají. Jak tedy získat přehled, kontext a kontrolu, které potřebujete k řízení všeho? A jak můžete řídit používání umělé inteligence, prosazovat zásady a předcházet rizikům?

Tenable AI Exposure přímo řeší tyto výzvy. Poskytuje základní funkce potřebné k ochraně citlivých informací a vynucování zásad přijatelného používání:

- Objevování: Komplexní identifikace veškerého generativního využití umělé inteligence v celé organizaci, včetně stínových instancí umělé inteligence, které by jinak mohly zůstat neodhaleny. To zajišťuje úplné pochopení toho, kde je umělá inteligence využívána, a to jak úmyslně, tak neúmyslně.

- Hluboký přehled: Klíčová analýza na úrovni okamžitého zjištění, která přesně odhalí, jaká data jsou zpřístupňována, když zaměstnanci interagují s generativními nástroji umělé inteligence. Tento podrobný vhled umožňuje organizacím pochopit povahu sdílených informací a identifikovat potenciální rizika.

- Vynucování: Poskytuje potřebná data pro efektivní vynucování zásad přijatelného užívání vaší organizace a ochranu citlivých informací. Poskytováním užitečných informací pomáhá Tenable AI Exposure bezpečnostním týmům implementovat a dodržovat pravidla správy a předcházet úniku dat a zneužití.

Díky těmto funkcím získáte proaktivní přístup ke správě složitostí generativní umělé inteligence v rámci podniku. Díky tomu mohou organizace přijímat inovace a zároveň zachovat robustní zabezpečení umělé inteligence a dodržování předpisů.

Pro další informace nás neváhejte kontaktovat.

Zdroj: Tenable