Vzhledem k tomu, že organizace dychtivě zavádějí umělou inteligenci, týmy kybernetické bezpečnosti se předhánějí v ochraně těchto nových systémů. V tomto speciálním vydání přehledu kybernetické bezpečnosti shrnujeme některé z nejlepších nedávných pokynů, jak odrazit útoky umělé inteligence a jak chránit vaše systémy umělé inteligence.

Pokud jste to propásli, zde je nový návod, jak chránit vaši organizaci před útoky podporovanými umělou inteligencí a jak zabezpečit vaše systémy a nástroje umělé inteligence.

OWASP: Jak chránit agentní aplikace s umělou inteligencí

Aplikace s agentní umělou inteligencí jsou velmi oblíbené, protože mohou jednat autonomně bez lidského zásahu. Proto také představují velkou bezpečnostní výzvu. Pokud aplikace s umělou inteligencí dokáže jednat sama o sobě, jak jí zabránit v tom, aby se stala podvodnou nebo byla napadena?

Pokud vytváříte nebo nasazujete tyto „autonomně řízené“ aplikace s umělou inteligencí, podívejte se na nového „Průvodce zabezpečením agentních aplikací“ od OWASP.

Tato příručka, publikovaná v srpnu, vám poskytuje „praktické a proveditelné rady pro návrh, vývoj a nasazení bezpečných agentních aplikací založených na modelech velkých jazyků (LLM)“.

Je to průvodce určený pro lidi v zákopech, včetně vývojářů, inženýrů AI/ML, bezpečnostních architektů a bezpečnostních inženýrů.

Mezi témata patří:

- Technické bezpečnostní kontroly a osvědčené postupy

- Bezpečné architektonické vzory

- Běžné strategie zmírňování hrozeb

- Poradenství v celém životním cyklu vývoje (návrh, sestavení, nasazení, provoz).

- Bezpečnostní aspekty komponent, jako jsou LLM, orchestrační middleware, paměť, nástroje a operační prostředí

Dokonce poskytuje příklady, jak aplikovat bezpečnostní principy v různých agentních architekturách.

Více informací o zabezpečení agentní umělé inteligence:

- „Často kladené otázky o protokolu kontextu modelu (MCP) a integraci s umělou inteligencí pro agentní aplikace“ (Tenable)

- „Kybernetická bezpečnost v roce 2025: Agentní umělá inteligence změní v nadcházejícím roce podnikovou bezpečnost a obchodní operace“ (SC World)

- „Jak by agenti umělé inteligence mohli s lidskou pomocí způsobit revoluci v SOC“ (Cybersecurity Dive)

- „Tři základní prvky pro bezpečnost agentní umělé inteligence“ (MIT Sloan Management Review)

- „Za hranicemi ChatGPT: Vzestup agentní umělé inteligence a její důsledky pro bezpečnost“ (CSO)

Anthropic: Jak útočník proměnil Clauda Codea v mistra hackera

Myslíte si, že příručka OWASP je jen teoretická? Zamyslete se znovu. V ostrém příkladu potenciálu zneužití agentní umělé inteligence nedávno odhalil dodavatel umělé inteligence Anthropic, jak sofistikovaný kybernetický zločinec zneužil jeho produkt Claude Code v „bezprecedentní míře“ v rozsáhlé kampani vydírání a krádeže dat.

Je to pozoruhodný příběh, a to i podle standardů světa umělé inteligence.

Hacker použil tento agentní kódovací nástroj pro umělou inteligenci k:

- Automatizujte průzkum.

- Sběr pověření obětí.

- Narušení sítí.

- Čiňte taktická a strategická rozhodnutí, jako je výběr dat k ukrást a vytváření „psychologicky cílených“ požadavků na vydírání.

- Analyzujte ukradené finanční údaje a nastavte ideální výši výkupného.

- Generujte „vizuálně alarmující“ výkupné.

Tento incident posouvá kybernetickou kriminalitu s pomocí umělé inteligence na novou úroveň.

„ Agentní umělá inteligence se stala zbraní. Modely umělé inteligence se nyní používají k provádění sofistikovaných kybernetických útoků, nejen k radám, jak je provést,“ napsal Anthropic v srpnovém blogovém příspěvku.

Tento nový druh zneužívání umělé inteligence agenty exponenciálně ztěžuje zabezpečení, protože nástroj je autonomní, takže se přizpůsobuje obraně v reálném čase.

V době, kdy Anthropic útočníka zastavil, bylo zasaženo nejméně 17 organizací, včetně zdravotnictví, záchranných složek, vládních a náboženských skupin.

Společnost Anthropic uvádí, že od té doby vytvořila nové klasifikátory – automatizované screeningové nástroje – a detekční metody, které tyto útoky rychleji odhalují.

Tento incident, který Antropic označil za „vibe hacking“, je jen jedním z 10 případů použití v reálném světě uvedených ve zprávě Anthropic „Threat Intelligence Report: August 2025“, která podrobně popisuje zneužívání nástrojů umělé inteligence společnosti.

Společnost Anthropic uvedla, že doufá, že zpráva pomůže širší komunitě v oblasti bezpečnosti umělé inteligence posílit jejich vlastní obranu.

„Ačkoli se případové studie týkají specificky Clauda,… pravděpodobně odrážejí konzistentní vzorce chování napříč všemi modely umělé inteligence na hranici konkurenčního prostředí. Dohromady ukazují, jak aktéři hrozeb přizpůsobují své operace tak, aby využili nejpokročilejší schopnosti dnešní umělé inteligence,“ uvádí se ve zprávě.

Pro více informací o zabezpečení umělé inteligence se podívejte na tyto blogy Tenable Research:

- „Často kladené otázky o modelu velkých jazyků DeepSeek (LLM)“

- „Často kladené otázky o protokolu MCP (Model Context Protocol) a integraci s umělou inteligencí pro agentní aplikace“

- „Často kladené otázky o vibračním kódování“

- „Zabezpečení umělé inteligence: Webové chyby se znovu objevují ve spěchu s využitím serverů MCP“

- „CVE-2025-54135, CVE-2025-54136: Často kladené otázky týkající se zranitelností v Cursor IDE (CurXecute a MCPoison)“

CSA: Tradiční IAM nedokáže zvládnout hrozby pro identitu ze strany agentů ze strany umělé inteligence

Antropický útok, při kterém agentní nástroj umělé inteligence ukradl přihlašovací údaje, zdůrazňuje zásadní zranitelnost: správu identit autonomních systémů. Co se stane, když těmto autonomním systémům umělé inteligence dáte klíče k digitálním identitám vaší organizace?

Je to otázka, která vedla Alianci pro cloudovou bezpečnost (CSA) k vypracování návrhu, jak lépe chránit digitální identity v agentních nástrojích umělé inteligence.

Ve svém novém dokumentu „Agentic AI Identity and Access Management: A New Approach“ (Správa identit a přístupu s agentickou umělou inteligencí: Nový přístup), publikovaném v srpnu, CSA tvrdí, že tradiční přístupy ke správě identit a přístupu (IAM) selhávají při aplikaci na systémy agentní umělé inteligence.

„Na rozdíl od konvenčních IAM protokolů určených pro předvídatelné lidské uživatele a statické aplikace fungují agentní systémy umělé inteligence autonomně, činí dynamická rozhodnutí a vyžadují detailní řízení přístupu, které se přizpůsobuje v reálném čase,“ uvádí se v dokumentu CSA.

Jejich řešení? Nový, adaptivní framework IAM, který se zbavuje starých, předdefinovaných rolí a oprávnění a nabízí nepřetržitý, kontextově orientovaný přístup.

Rámec je postaven na několika základních principech:

- Architektura nulové důvěry

- Decentralizovaná správa identit

- Dynamické řízení přístupu založené na zásadách

- Nepřetržité monitorování

Navrhovaný rámec CSA je postaven na „bohatých, ověřitelných“ identitách, které sledují schopnosti, původ, chování a bezpečnostní stav agenta umělé inteligence.

Mezi klíčové komponenty frameworku patří služba pojmenování agentů (ANS) a jednotná globální vrstva pro správu relací a vynucování politik.

Více informací o IAM v systémech umělé inteligence:

- „Nová identita: Boom agentní umělé inteligence riskuje narušení norem IAM“ (SC World)

- „Řízení expozice v oblasti umělé inteligence“ (Tenable)

- „Nový rámec pro identitu s nulovou důvěrou pro agentickou umělou inteligenci: Decentralizované ověřování a detailní řízení přístupu“ (výzkumníci z několika univerzit a společností, včetně MIT a AWS, prostřednictvím Arvix.org)

- „Zpráva o rizicích cloudových umělých inteligencí od Tenable za rok 2025“ (Tenable)

- „Podniky musí přehodnotit IAM, protože počet agentů umělé inteligence převyšuje počet lidí v poměru 10:1“ (VentureBeat)

OpenAI: Útočníci zneužívají ChatGPT k vylepšování starých triků

Zatímco agentní útoky s využitím umělé inteligence ilustrují nové metody zneužívání umělé inteligence, útočníci také zneužívají konvenční chatboty s umělou inteligencí k méně obvyklým účelům.

Například, jak nedávno odhalila společnost OpenAI, útočníci se v poslední době pokusili použít ChatGPT k vylepšování malwaru, nastavení center pro řízení a kontrolu, psaní vícejazyčných phishingových e-mailů a spuštění kybernetických podvodů.

Jinými slovy, tito útočníci se nesnažili použít ChatGPT k vytváření superútoků na úrovni sci-fi, ale hlavně se snažili zesílit své klasické podvody, uvádí zpráva OpenAI „Narušení škodlivého používání umělé inteligence: aktualizace“.

„Stále vidíme, jak útočníci přizpůsobují umělou inteligenci starým postupům, aby se pohybovali rychleji, a ne aby z našich modelů získali nové útočné schopnosti,“ napsal OpenAI ve zprávě zveřejněné v říjnu.

Zpráva identifikuje několik klíčových trendů mezi aktéry hrozeb:

- Používání více modelů umělé inteligence

- Přizpůsobují své techniky tak, aby skryli využití umělé inteligence

- Fungování v „šedé zóně“ s požadavky, které nejsou zjevně škodlivé

Mezi incidenty popsané ve zprávě patří škodlivé použití ChatGPT těmito osobami:

- Kyberzločinci z rusky mluvících, korejsky mluvících a čínsky mluvících skupin vylepšují malware, vytvářejí phishingový obsah a ladí nástroje

- Autoritářské režimy, konkrétně osoby spojené s Čínskou lidovou republikou (ČLR), aby navrhly rozsáhlé monitorování a profilování sociálních médií, včetně systému pro sledování Ujgurů

- Organizované podvodné sítě, pravděpodobně se sídlem v Kambodži, Myanmaru a Nigérii, za účelem rozšíření podvodů překladem zpráv a vytvářením falešných profilů.

- Státem podporované vlivové operace z Ruska a Číny za účelem generování propagandy, včetně scénářů videí a příspěvků na sociálních sítích

„Naše veřejné podávání zpráv, vymáhání politik a spolupráce s kolegy si kladou za cíl zvýšit povědomí o zneužívání a zároveň zlepšit ochranu pro každodenní uživatele,“ napsala OpenAI ve svém prohlášení s názvem „Narušení škodlivého používání umělé inteligence: říjen 2025“.

Pro více informací o zabezpečení umělé inteligence se podívejte na tyto zdroje Tenable:

- „Zpráva o rizicích cloudové umělé inteligence za rok 2025: Pomáháme vám vytvářet bezpečnější modely umělé inteligence v cloudu“ (webinář na vyžádání)

- „Bezpečnost cloudu a umělé inteligence na bodě zlomu – Pochopení výzvy složitosti“ (přehled řešení)

- „Řízení expozice v oblasti umělé inteligence“ (webinář na vyžádání)

- „Odborné rady pro posílení bezpečnosti umělé inteligence“ (blog)

- „Umělá inteligence je vaším novým útočným povrchem“ (webinář na vyžádání)

Představuje váš kamarád kódující umělou inteligenci bezpečnostní riziko?

Hackeři nejsou jediní, kdo používá umělou inteligenci k programování. Vaši vlastní vývojáři také. Zvýšení produktivity, kterého získají díky asistentům programování s umělou inteligencí, však může být nákladné, pokud nejsou opatrní.

Aby pomohla vývojářům s tímto problémem, vydala Nadace pro bezpečnost otevřeného zdrojového kódu (OpenSSF) dokument „Průvodce zaměřený na bezpečnost pro instrukce asistenta AI kódu“.

„Asistenti pro tvorbu kódu s umělou inteligencí jsou mocné nástroje,“ uvádí se na blogu OpenSSF „Nové pokyny OpenSSF k instrukcím pro asistenty pro tvorbu kódu s umělou inteligencí“. „Vytvářejí však také bezpečnostní rizika, protože výsledky, které získáte, silně závisí na tom, co požadujete.“

Průvodce, publikovaný v září, poskytuje vývojářům tipy a osvědčené postupy, jak tyto pomocníky s umělou inteligencí pobízet ke snížení rizika, že budou generovat nebezpečný kód.

Konkrétně si průvodce klade za cíl zajistit, aby asistenti kódování s umělou inteligencí zvažovali:

- Zabezpečení kódu aplikace, jako je ověřování vstupů a správa tajných kódů.

- Bezpečnost dodavatelského řetězce, jako je výběr bezpečných závislostí a používání správců balíčků.

- Problémy specifické pro platformu nebo jazyk, jako je například aplikace osvědčených bezpečnostních postupů u kontejnerů.

- Bezpečnostní standardy a rámce, jako například od OWASP a SANS Institute.

„V praxi to znamená, že se do vaší kódové základny dostane méně zranitelností,“ uvádí se v průvodci.

Více informací o kybernetických rizicích asistentů kódování s umělou inteligencí:

- „Hackeři chystají pasti na vibrační kodéry: Asistenti s umělou inteligencí mohou doručovat malware“ (Cybernews)

- „Kybernetická rizika kódu generovaného umělou inteligencí“ (Georgetownská univerzita)

- „Bezpečnostní rizika kódu generovaného umělou inteligencí a jak je řídit“ (TechTarget)

- „Rizika kódu generovaného umělou inteligencí: Co by měli vědět CISO“ (ITPro)

- „Asistent umělé inteligence GitLabu otevřel vývojářům prostor pro krádeže kódu“ (Dark Reading)

PwC: Kybernetické týmy nemohou mít dostatek umělé inteligence

A konečně, zde je návod, jak se organizace brání. Silně se opírají o umělou inteligenci, aby posílily svou kybernetickou obranu, a to i tím, že upřednostňují používání obranných agentních nástrojů umělé inteligence.

Vyplývá to z nové zprávy společnosti PwC s názvem „2026 Global Digital Trust Insights: C-suite playbook and findings“ (Globální digitální důvěra v roce 2026: Příručka a zjištění pro vrcholové vedení), která vychází z globálního průzkumu mezi téměř 4 000 manažery v oblasti obchodu a technologií.

„Potenciál umělé inteligence pro transformaci kybernetických schopností je jasný a dalekosáhlý,“ uvádí se v článku společnosti PwC s hlavními body zprávy, který byl publikován v říjnu.

Například organizace upřednostňují používání umělé inteligence ke zlepšení způsobu alokace kybernetických rozpočtů, využívání spravovaných služeb kybernetické bezpečnosti a řešení nedostatků v kybernetických dovednostech.

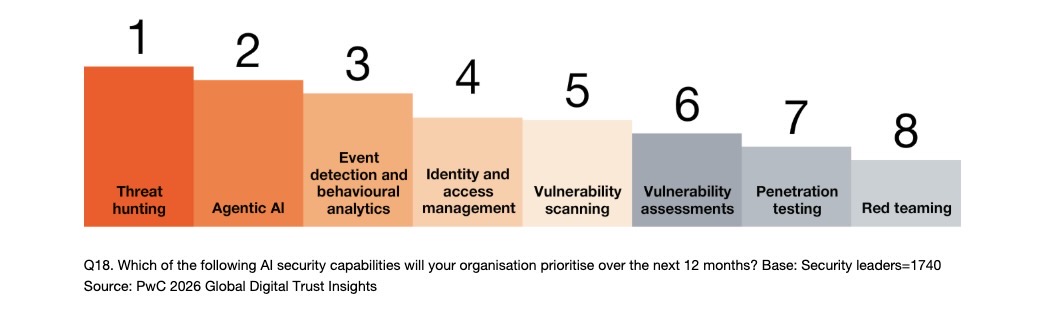

Pokud jde o priority respondentů v oblasti kybernetické bezpečnosti s využitím umělé inteligence v nadcházejícím roce, na prvním místě se umístilo hledání hrozeb, následované agentní umělou inteligencí. Mezi další oblasti patří správa identit a přístupů a skenování/hodnocení zranitelností.

Organizace budou v příštích 12 měsících upřednostňovat bezpečnostní schopnosti umělé inteligence.

Organizace mezitím plánují v nadcházejícím roce využívat agentní umělou inteligenci především k posílení cloudové bezpečnosti, ochrany dat a bezpečnostních operací. Mezi další prioritní oblasti agentní umělé inteligence patří testování zabezpečení, správa, rizika a dodržování předpisů a správa identit a přístupu.

„Firmy si uvědomují, že agenti umělé inteligence – autonomní, cílené systémy schopné vykonávat úkoly s omezeným lidským zásahem – mají obrovský potenciál transformovat jejich kybernetické programy,“ uvádí se ve zprávě.

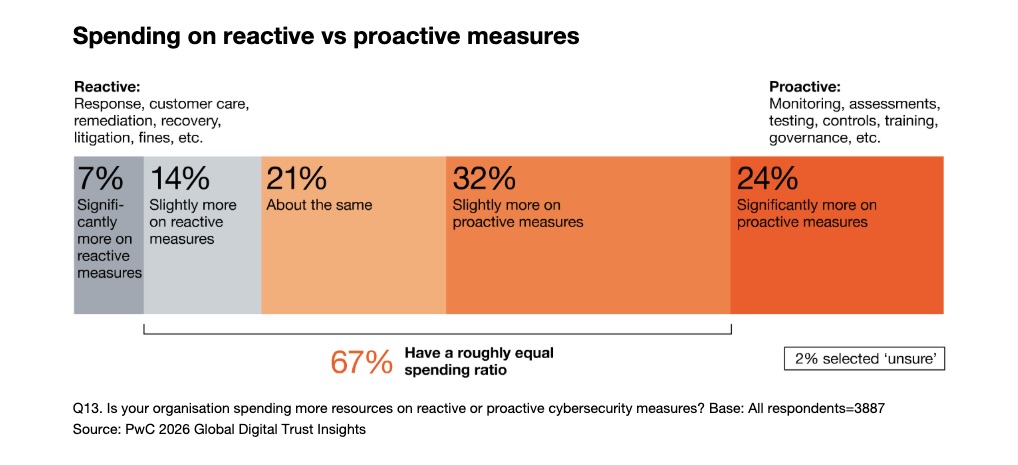

Kromě umělé inteligence zpráva také naléhavě vyzývá kybernetické týmy, aby upřednostňovaly prevenci před reakcí. Proaktivní práce, jako je monitorování, hodnocení, testování a školení, je vždy levnější než krizová alternativa reakce na incidenty, nápravy, soudních sporů a pokut. Přesto pouze 24% organizací uvedlo, že na proaktivní opatření vynakládají „výrazně více“.

Mezi další témata, kterými se zpráva zabývá, patří geopolitická rizika, kybernetická odolnost, hrozba kvantových počítačů a nedostatek kybernetických dovedností.

Více informací o zabezpečení dat s využitím umělé inteligence naleznete v těchto zdrojích Tenable:

- „ Posílejte své zabezpečení v cloudu ochranou cloudových dat a zdrojů umělé inteligence“ (blog)

- „ Zpráva o rizicích umělé inteligence v cloudu Tenable Cloud 2025“ (zpráva)

- „ Nová zpráva Tenable: Jak složitost a slabé zabezpečení umělé inteligence ohrožují cloudová prostředí“ (blog)

- „ Zabezpečení povrchu pro útok AI: Oddělení neznámého od dobře pochopeného“ (blog)

- „ Dilema bezpečnosti umělé inteligence: Navigace ve světě cloudové umělé inteligence s vysokými sázkami“ (blog)

Pro další informace nás neváhejte kontaktovat.

Zdroj: Tenable